Was versteht man unter Crawler?

Unter Crawler (auch Webcrawler, Bots, Spider, Robot, Searchrobot genannt) versteht man ein Computerprogramm, welches von Suchmaschinen, wie Google, verwendet wird, um das Internet zu durchforsten. Dabei werden von dem Crawler automatisch Dokumente durchsucht und Webseiten analysiert und indexiert. Die gesammelten Informationen werden in der Datenbank abgelegt.

Welche Funktion hat der Crawler?

Ein Crawler ist wie ein Archiv, dass die gefundenen Informationen in Kategorien einteilt und indiziert. Dies gibt Google die Möglichkeit, schnell auf die genauen Suchanfragen der User zu antworten. Ein Crawler besteht aus einem Code von Skripten und Algorithmen, der nicht eigenständig handelt. Die Befehle und Aufgaben, die der Crawler von einem Computerprogramm erhält, führt er automatisch und kontinuierlich aus. Diese müssen aber im Vorfeld klar definiert werden.

Die Hauptaufgabe eines Crawlers ist es, sich durch das Internet über Links (auch Hyperlinks genannt) von bereits indexierten Webseiten zu bewegen und die URLs abzuspeichern. Der Weg, den der Crawler durch das World Wide Web bewältigt, ist vergleichbar mit einem Spinnennetz. Crawler sind für die Suchmaschinen elementar wichtig, damit die Inhalte im Netz gefunden und indexiert werden können.

Sind die Inhalte indexiert, werden diese auf den Suchergebnisseiten der Suchmaschine angezeigt. Der Index ist abhängig vom jeweiligen Algorithmus. Der Google-Algorithmus beispielsweise entscheidet, in welcher Anordnung die Suchergebnisse für bestimmte Suchanfragen dargestellt werden.

Beispiel Google Crawler

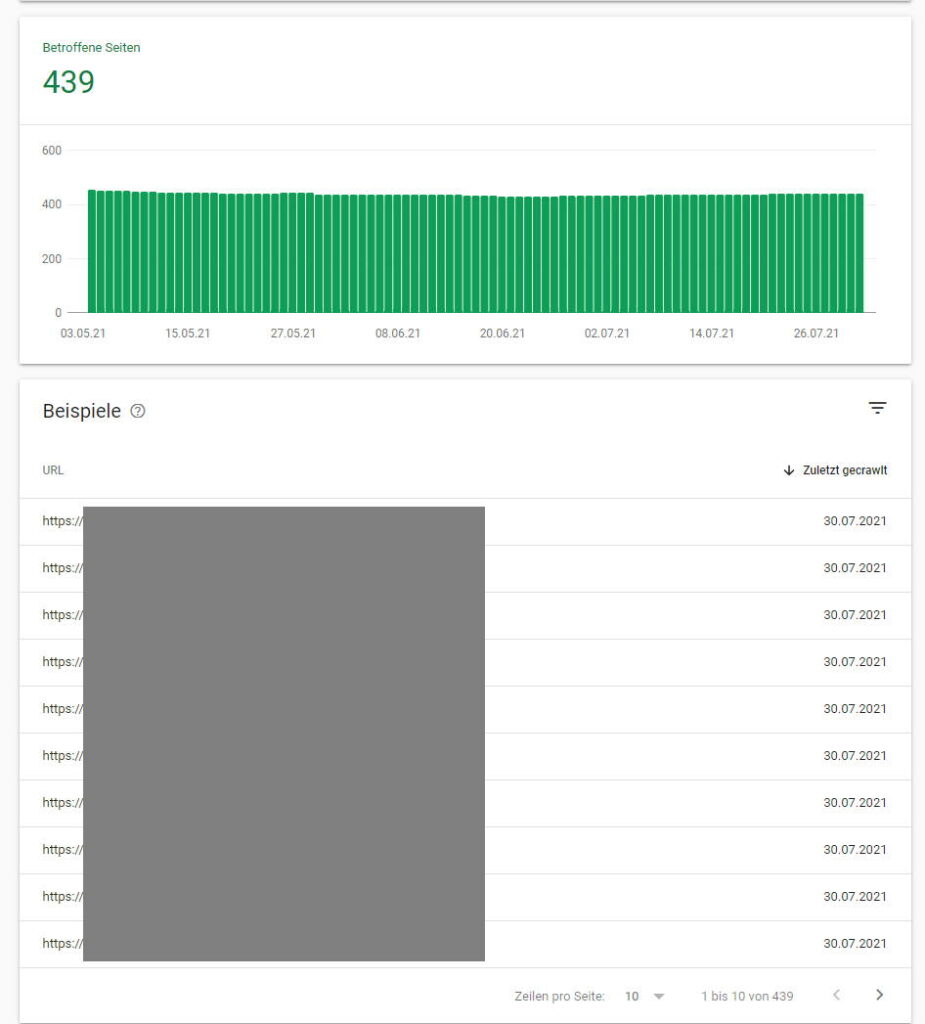

Um die Indexierung einer Seite zu beschleunigen kann die Google Search Console verwendet werden. Checke mithilfe des URL-Prüftool, ob deine Seite bereits indexiert wurde.

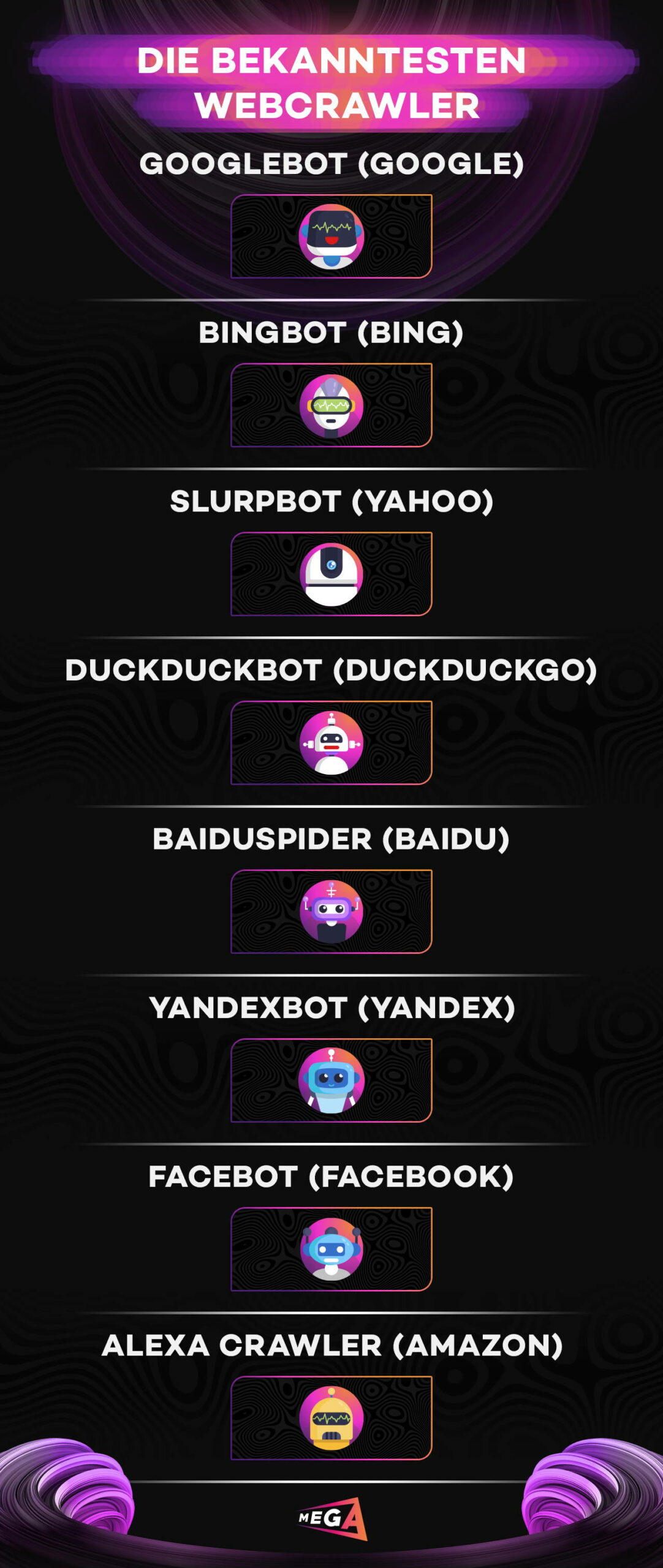

Welche Formen des Crawlers gibt es?

| Suchmaschinen | Die Webcrawler durchsuchen das Internet durchsuchen und indexieren Dokumente und Webseiten |

| Focused Crawler | Die Focused Crawler fokussieren sich z.B. bei der Indexierung auf themenrelevante Webseiten |

| Preisvergleichsportale | Die Webcrawler durchsuchen das Internet nach bestimmten Angeboten bzw. Produkten |

| Data Mining | Die Webcrawler sammeln öffentlich zugängliche Adressen und Kontaktdaten, wie E-Mail-Adressen von Unternehmen |

| Webanalyse-Tools | Die Webcrawler analysieren Webseiten, um Daten über Seitenaufrufe und ein- und ausgehenden Links zu sammeln |

Was ist der Unterschied zwischen Crawler und Scraper?

Das Ziel des Scrapers ist es, Content von anderen Webseiten zu sammeln und diesen auf anderen Webseiten in abgeänderter Form zu platzieren. Das Scraping ist den Black Hat Methoden zuzuordnen. Diese ist allerdings eher unerwünscht bei Google. Im Gegensatz zum Crawler, für den die Metadaten wichtig sind, zielt der Scraper auf eindeutige Inhalte ab.

Den Crawler blockieren bzw. sperren – Wie geht das?

Als Webseiten-Betreiber ist es möglich, bestimmte Crawler auf der eigenen Webseite zu blockieren. Mithilfe der robots.txt-Datei kann dies verhindert werden. Allerdings ist die Indexierung bestimmter Inhalte durch Suchmaschinen nicht komplett ausgeschlossen. Dies passiert erst dann, wenn der Noindex-Tag oder Canonical-Tag im <head>-Bereich eingefügt wird.

Bots unterteilen sich in Good Bot und Bad Bot. Wenn du wissen willst, welche das genau sind, dann schaue hier vorbei.

Fazit zum Crawler

Für viele Webmaster ist die Steigerung der Besucheranzahl und die Steigerung des Bekanntheitsgrades das primäre Ziel. Daher empfiehlt es sich die Webseite zu indexieren, wenn diese in den Suchergebnissen auf den vorderen Plätzen erscheinen soll. Dafür muss das Crawling der Webseite erlaubt sein. Sind die Crawler gesperrt, wird die Webseite auch nicht in den SERPs angezeigt. Daher ist es sinnvoll, dass die Webseite regelmäßig gecrawlt wird.

Wichtig zu wissen ist, dass je flacher und logischer die URL-Struktur ist, diese womöglich auch einfacher gecrawlt wird. Zudem kann eine häufige Verlinkung einer Webseite dazu führen, dass diese öfter und länger gecrawlt wird. Entscheidend für eine hohe Crawling-Frequenz ist eine hohe Backlinkanzahl und eine strukturierte und überschaubare interne Verlinkung.